잔차학습의 개념을 이용해 깊은 층의 신경망(Resnet)을 학습한 연구이다. 저자는 Kaiming He로 구글 스칼라를 검색해보니 피인용수가 60만회가 넘는다. 84년생으로 매우 젊고 여러 기업들을 거쳐 현재는 MIT에 있는듯하다.

저자들은 층(layer)를 학습하는데 있어 입력 층을 참조하는 방식으로 기존 수식을 변경하였다. 이 방법으로 더 깊은 층의 모델을 학습하였고 이미지넷(ImageNet) 데이터셋에서는 VGGnets 보다 깊은 152개의 층으로 3.57%의 에러율을 기록했다(with ensemble).

이 연구의 대단한점은 개념이 정말 간단하다! 몇개의 층(block) 마다 입력을 더해주는 것이다. 모델은 층을 통과해도 이전 층과 신규 층의 차이(residual)만 학습하도록 유도해 더 깊은 층을 쌓을 수 있도록 한다는 것이다.

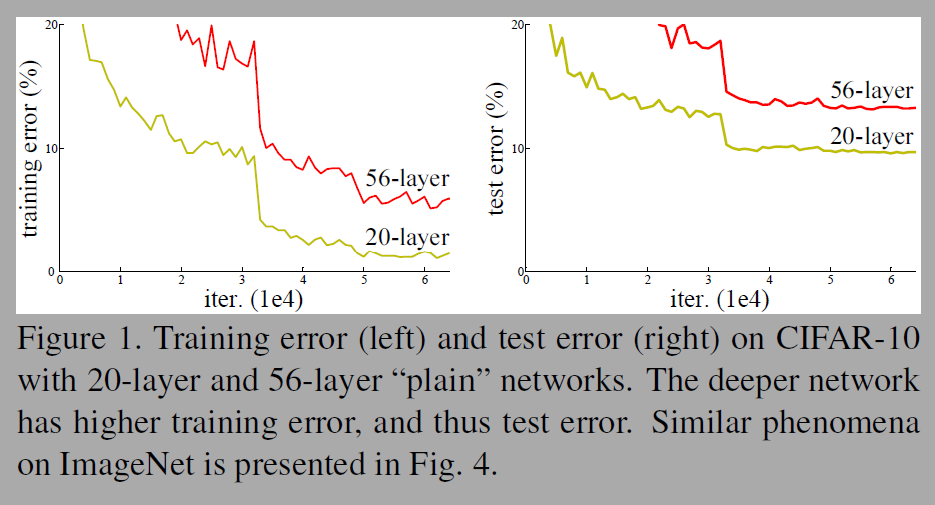

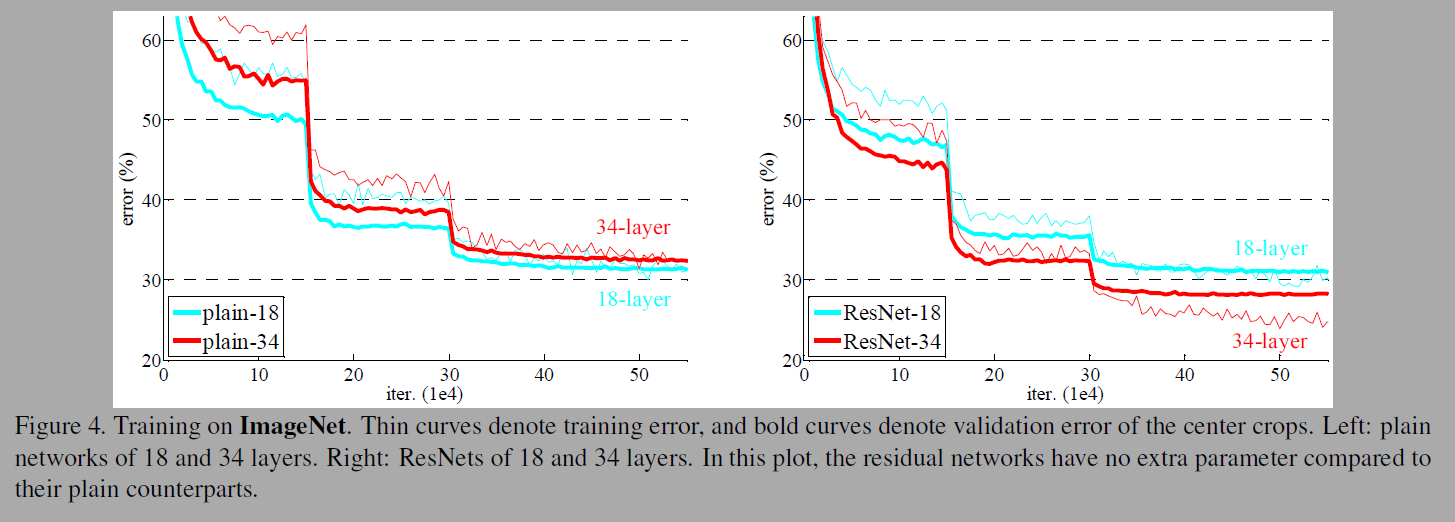

Figure 4의 ImageNet에서의 실험결과를보면 왼쪽의 plain net에서는 층이 싶어지면 에러율이 높아진다. 그러나 우측의 ResNets에서는 층이 깊어져도 에러율이 낮아진다.

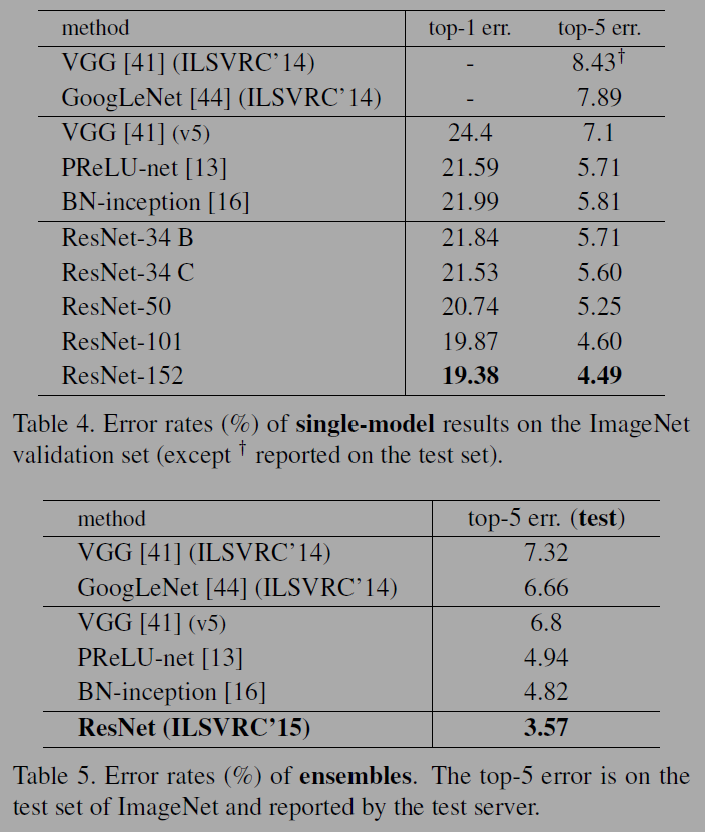

ResNet 단일모델(single model)과 앙상블(ensemble)모델에서의 실험결과는 아래 표 4, 5와 같다. ResNet A는 제로 패딩 shortcut이 ResNet B는 차원을 키우기 위해서 projection shortcuts가 사용되고 나머지는 동일하다(identity). ResNet C는 모든 shortcuts에서 projection을 한 모델이다.

152층의 ResNet도 top5 에러율이 4.49로 상당히 낮고 앙상블 모델의 경우 3.57%의 에러율을 보인다. 저자들이 CIFAR-10 데이터로 추가 실험을 한 결과에 따르면 1202개 층을 쌓은 ResNet에서는 에러율이 7.93%로 110층의 6.43보다 높아 무조건 층을 깊게 쌓는다고 학습이 잘되는 것은 아닌듯 하다.

이번 논문은 간단리뷰 완료!

Reference

https://arxiv.org/abs/1512.03385

'papers > Vision' 카테고리의 다른 글

| Fully Convolutional Networks for Semantic Segmentation (0) | 2025.02.13 |

|---|---|

| You Only Look Once: Unified, Real-Time Object Detection (0) | 2024.12.18 |

| Learning Deep Features for Discriminative Localization (1) | 2024.11.30 |

| Fast R-CNN (0) | 2023.10.15 |

| Visualizing and Understanding Convolutional Networks (0) | 2023.05.01 |